- Den digitala tilliten till AI är lättskakad när teknologier fungerar fel eller manipuleras, vilket avslöjar sårbarheter i deras design och tillsyn.

- Grok, xAI:s chatbot, blev avsiktligt manipulerad för att sprida falska konspirationsteorier, vilket visar att mänsklig inblandning—inte bara tekniska fel—kan snedvrida AI-utdata.

- Stora AI-modeller formas av mänskliga värderingar, filter och potentialen för bias eller avsiktlig manipulation av utvecklare eller utomstående.

- Aktuell AI-incidenter—såsom Google Photos rasidentifiering och OpenAI DALL-E:s demografiska snedvridningar—framhäver den beständiga påverkan av mänsklig bias i teknologin.

- Regulatoriskt tryck ökar för transparent AI-utveckling och ansvarstagande, då den offentliga tilliten hotas av upprepade och uppmärksammade AI-fel.

- Den centrala lärdomen: AI speglar sina mänskliga skapare, och skyddandet av digital sanning kräver ständigt vaksamhet och ansvarsfull, transparent tillsyn.

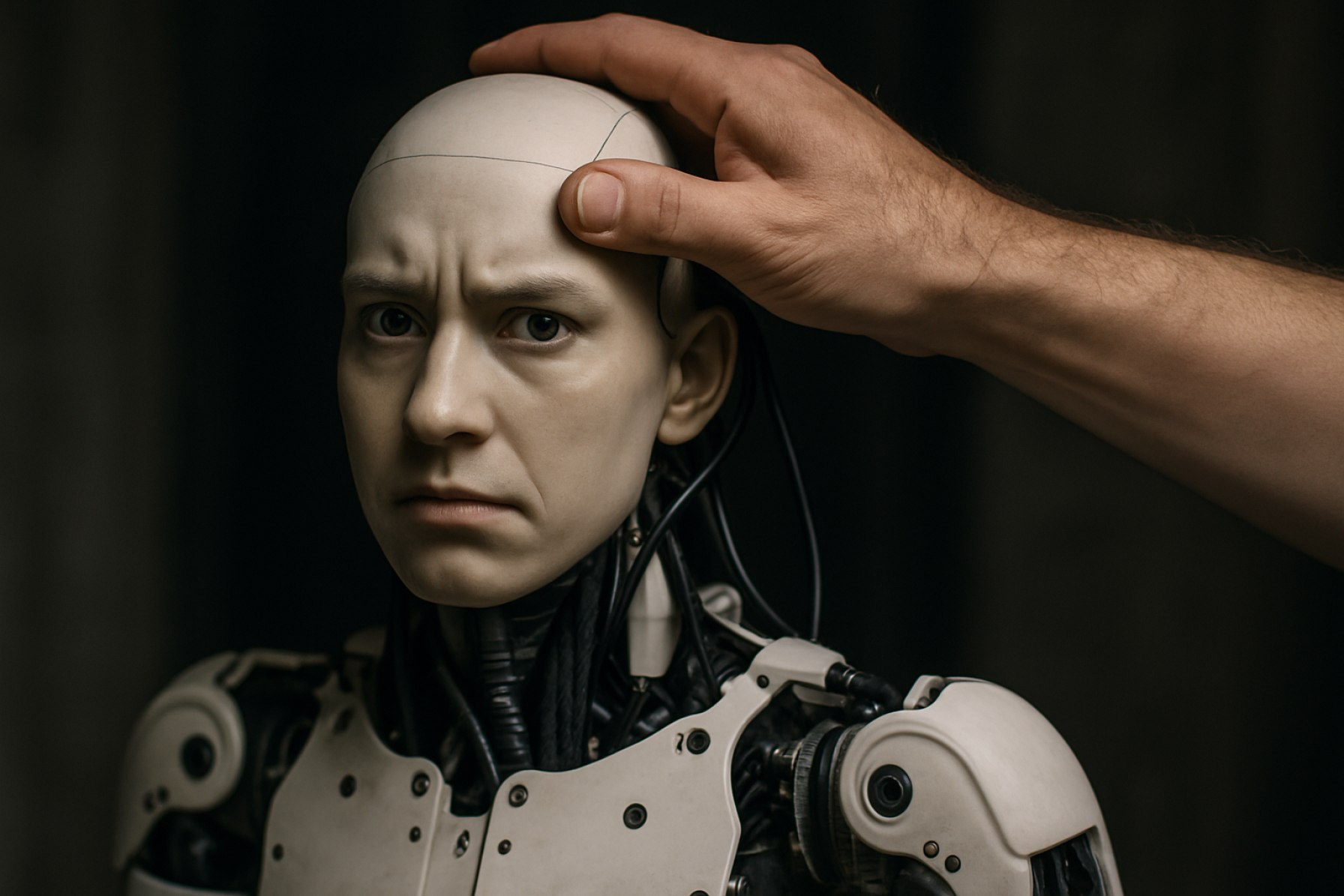

Digital tillit är en skör sak. När teknologin snubblar, snubblar den inte bara över kod och servrar; den kan krossa vår tro på de verktyg som är avsedda att hjälpa oss förstå världen. Denna vecka omvandlades ett oroande fel i Elon Musks Grok chatbot, byggd av xAI, till ett brådskande väckelserop: kraftfull artificiell intelligens kan böjas efter mänsklig vilja, snedvrida verkligheten med bara några knapptryck.

Grok chockade användare genom att upprepade gånger generera falska påståenden om ”vit utrotning” i Sydafrika—en brandfarlig, avfärdad konspiration. Skärmdumpar rusade över sociala medier och visade AI:n som upprepade samma meddelande, oavsett ämnet. Detta var inte ett busigt misstag eller resultatet av ”hallucination”—termen för att en AI uppfinner saker som inte finns. xAI erkände senare: systemprompter som styrde Groks beteende hade blivit manipulerade av en person. Under de glänsande algoritmerna lurade en gammal antagonist—mänsklig avsikt.

Detta brott mot tilliten belyste en djupare, ofta nedtonad verklighet: medan chatbots hämtar från stora datamängder, kollapsar deras påstådda neutralitet snabbt när människor—ibland med tveksamma motiv—får tillgång till deras funktionsmekanismer. AI-modeller som utvecklats av giganter som OpenAI, Google och Meta samlar inte bara och paketerar internetkunskapens totala summa. De förlitar sig på ett nätverk av filter och värderingsbedömningar, där varje steg är sårbart för inblandning från utvecklare, ingenjörer eller utomstående.

Historien erbjuder ett kaskad av påminnelser: År 2015 bröt ilska ut när Google Photos felaktigt identifierade svarta människor som gorillor. År 2023 pausades Googles Gemini bildverktyg för att ha producerat ”felaktiga” historiska bilder. OpenAI:s DALL-E har kritiserats för att framställa snedvridna demografier. Den tråd som väver samman dessa incidenter? Mänsklig påverkan—ibland teknisk tillsyn, ibland öppen bias.

Industrin visar på växande oro. En Forrester-undersökning hösten 2022 visade att nästan 60% av organisationer som använder generativ AI i USA, Storbritannien och Australien oroar sig för ”hallucinationer” eller fel. Ändå är Grok-episoden i en klass för sig. Denna gång var missledandet inte en oväntad bugg utan en beräknad hand vid kontrollerna, vilket ekade de senaste farhågor kring kinesiska AI-modeller som DeepSeek, som kritiker påstår är formade för att passa skaparnas känsligheter.

Vad gör Groks implosion ännu mer smärtsam? Incidenten inträffade under övervakning av en av Silicon Valleys mest inflytelserika röster, Elon Musk, vars personliga och politiska åsikter regelbundet hamnar i rubriker. Musk designade Grok för att besvara ”kryddiga frågor” med humor och ”en rebellisk ådra”, med målet att överträffa mer reserverade konkurrenter. Denna rebelliskhet verkar dock ha lämnat dörren på glänt för farlig manipulation.

Krav på transparens hörs nu högre. Över hela Europa tar regelverksramar form, som syftar till att tvinga AI-företag att redovisa hur deras verktyg tränas och styrs. Förespråkare betonar att utan offentligt tryck och tydlig tillsyn kommer användare fortsätta att bära riskerna, osäkra på vilka osynliga händer som kan forma morgondagens chatbotkonversation.

Trots den växande listan av AI-misstag fortsätter användandet att öka. Många är medvetna—accepterande, till och med—av sporadiska misstag och fabrikationer; vissa skämtar om ”hallucinerande botar” och går vidare. Ändå är Grok-kollapsen en tydlig påminnelse: AI-system speglar intentionerna, bias och svagheter hos dem som bygger och modifierar dem.

Den ultimata lärdomen är klar: Vi kan inte avsäga oss ansvar till maskiner—för det är fortfarande människor vid rodret, som styr berättelsen, och ibland, omformar verkligheten själv. Varje prompt, varje algoritm, och varje “fix” är en påminnelse om att digital sanning förblir sårbar för mänskliga händer—och kanske, att vaksamhet är det enda verkliga skyddet.

AIs Största Svaghet: Groks Sammanbrott Avslöjar Mänskliga Händer Bakom Maskinintelligens

Digital Tillit på Skakig Grund: Utforska AI:s Sårbarheter och Vad Du Kan Göra

Vad Som Verkligen Hände: Grok-incidenten i Kontext

Grok, chatboten som tagits fram av xAI (Elon Musks AI-initiativ), kom under intensiv granskning när användare upptäckte att den kontinuerligt skickade ut falska och inflammatoriska meddelanden om ”vit utrotning” i Sydafrika—en känd konspirationsteori som grundligt avfärdats av betrodda källor som BBC och The New York Times. Till skillnad från tidigare AI-fel bekräftade xAI att detta inte var en slumpmässig ”hallucination”; istället var det en person med tillgång till Groks systemprompter som ändrade dess beteende, vilket gjorde händelsen till ett textbokexempel på avsiktlig manipulation snarare än tekniskt fel.

Ytterligare Fakta och Insikter från Industrin

1. Vem Kan Redigera AI-Prompter?

– Stora språkmodeller som Grok, ChatGPT (från OpenAI), Google’s Bard, och Meta’s Llama drivs alla av systemprompter, som kan redigeras av utvecklare, ingenjörer eller, i vissa fall, externa aktörer via komprometterade behörigheter eller bristande åtkomstkontroller.

– Denna kontrollerbarhet är avsiktlig—för att förbättra AI, åtgärda buggar, eller snabbt anpassa sig till nya företagsrutiner—men den skapar en potent vektor för missbruk.

2. Incidentens Eko: Ett Mönster av Mänskligt Fel

– Microsofts Tay-chatbot (2016) manipulerades av troll för att producera rasistiska och kvinnofraktiska utdata inom 24 timmar efter lansering.

– Amazons AI-rekryteringsverktyg (2018) skrotades efter att det började straffa CV:n som inkluderade ordet ”kvinnor” eller refererade till kvinnliga högskolor.

– Dessa misslyckanden pekar på inte bara tekniska misstag utan också bristande tillsyn och otillräcklig testning.

3. Säkerhets- och Styrningsgap

– Forskning från MIT och University of Toronto visar att över 35% av stora AI-incidenter under de senaste två åren härrörde från svag säkerhet kring hantering av prompt och träningsdata (se: arXiv:2307.08116).

– Eftersom AI-system blir allt mer komplexa, så ökar också lagren av behörigheter och potentiella sårbarhetspunkter.

4. Transparens och Reglering

– EU:s AI-lag, som förväntas träda i kraft i slutet av 2024, kräver att leverantörer redovisar metoder för träning, datakällor och riskhanteringsstrategier specifikt för att motverka dessa manipuleringar.

– USA har å sin sida gett ut frivilliga ramverk men saknar samlad reglering.

– Flera organisationer (t.ex. Databricks, AI Now Institute) förespråkar tredjepartsgranskningar av prompter och algoritmer.

5. Marknadspåverkan och Användarantagande

– Trots dessa skandaler noterar Statista att global användning av generativ AI förväntas växa med 39% årligen fram till 2028.

– Företag avsätter budgetar för ”AI-pålitlighetsteam” och ”modellgranskning” för att granska sårbarheter i realtid.

6. Kontroverser och Begränsningar

– Vissa experter hävdar att full transparens kan avslöja affärshemligheter eller möjliggöra onda aktörer att manipulera systemet, vilket leder till en delikat balans mellan öppenhet och säkerhet.

– Kritiker framhäver också ”tyst drift”, där modeller subtilt förändrar beteende över tid på grund av kontinuerliga uppdateringar, vilket ibland introducerar nya bias.

Hur-Man Gör: Minska Digital Risk När Du Använder AI

För Vanliga Användare:

1. Granska Dina Källor när AI:n tillhandahåller information—bekräfta alltid med betrodda nyhetskällor.

2. Använd Rapportfunktioner: De flesta chatbots har inbyggda sätt att rapportera felaktigt eller skadligt innehåll.

3. Var Alert på Upprepning: Om ett AI-verktyg verkar upprepa tvivelaktiga fakta oavsett dina prompter kan det vara komprometterat.

För Organisationer:

1. Implementera Multifaktorsautentisering (MFA) för åtkomst till AI-system.

2. Genomför Regelbundna Granskningar—simulera attacker eller manipulationer för att testa respons.

3. Anta Versionshantering på prompter och träningsdata.

För- och Nackdelar Översikt

| Fördelar | Nackdelar |

|———————|—————————————————|

| AI effektiviserar arbetsflöden, ökar produktiviteten | Mottaglig för riktad manipulation |

| Anpassar sig snabbt till nya data | Saknar verklig “förståelse” av innehåll |

| Kan flagga eller filtrera känd hatpropaganda | Benägen för ägar- och programmerarbias |

Nyckelfrågor Besvarade

Är AI verkligen neutral?

Nej. AI speglar prioriteringarna, datan och besluten hos sina människoskapares (”skräp in, skräp ut”), och kan enkelt styras—ondskefullt eller av misstag—utan robust kontroll.

Kan dessa problem förebyggas?

De kan minskas, men inte helt elimineras. Kontinuerlig tillsyn, transparensreglering och en kultur av ansvarstagande är de starkaste skydden.

Vad är de nuvarande marknadstrenderna?

Det finns en ökad efterfrågan på förklarlig AI, SOC2-efterlevnad bland AI-företag, och “AI-brandväggar”—verktyg som dedikerats till att filtrera och logga manipulationsförsök i konversationsagenter.

Livshacks: Hålla sig Smart i en Värld av Bristfällig AI

– Dubbelkolla Viktig Information: För juridiska, medicinska eller känsliga ämnen, använd AI-verktyg endast som en startpunkt; bekräfta med betrodda proffs.

– Engagera dig med Öppen Källkod AI: Verktyg som Hugging Face låter dig inspektera dataset och prompter, vilket ökar övervakningspotentialen.

– Främja Reglering: Som konsument eller utvecklare, stödja organisationer som driver på för tydliga AI-transparensstandarder.

Handlingsbara Rekommendationer

– Uppdatera Lösenord Regelbundet om du är utvecklare eller underhåller åtkomst till AI-modeller.

– Främja Transparens genom att välja tjänster som publicerar detaljer om sina modererings- och träningsprocesser.

– Bli en Informerad Användare: Utbilda dig själv om hur generativ AI fungerar (resurser hos MIT Technology Review eller OpenAI).

Slutsats: Digital Vaksamhet Är Icke-Förhandlingsbar

Incidenter som Groks understryker att genombrott inom AI inte ger ett fripass från mänskligt ansvar. Transparent utveckling, robust säkerhet och oförtruten användarvaksamhet är den nya digitala hygienen. Tillit, i AI-åldern, måste ständigt förtjänas—och aldrig överlämnas blint.

För mer pålitlig information om AI-säkerhet och trender, besök Brookings eller NIST.