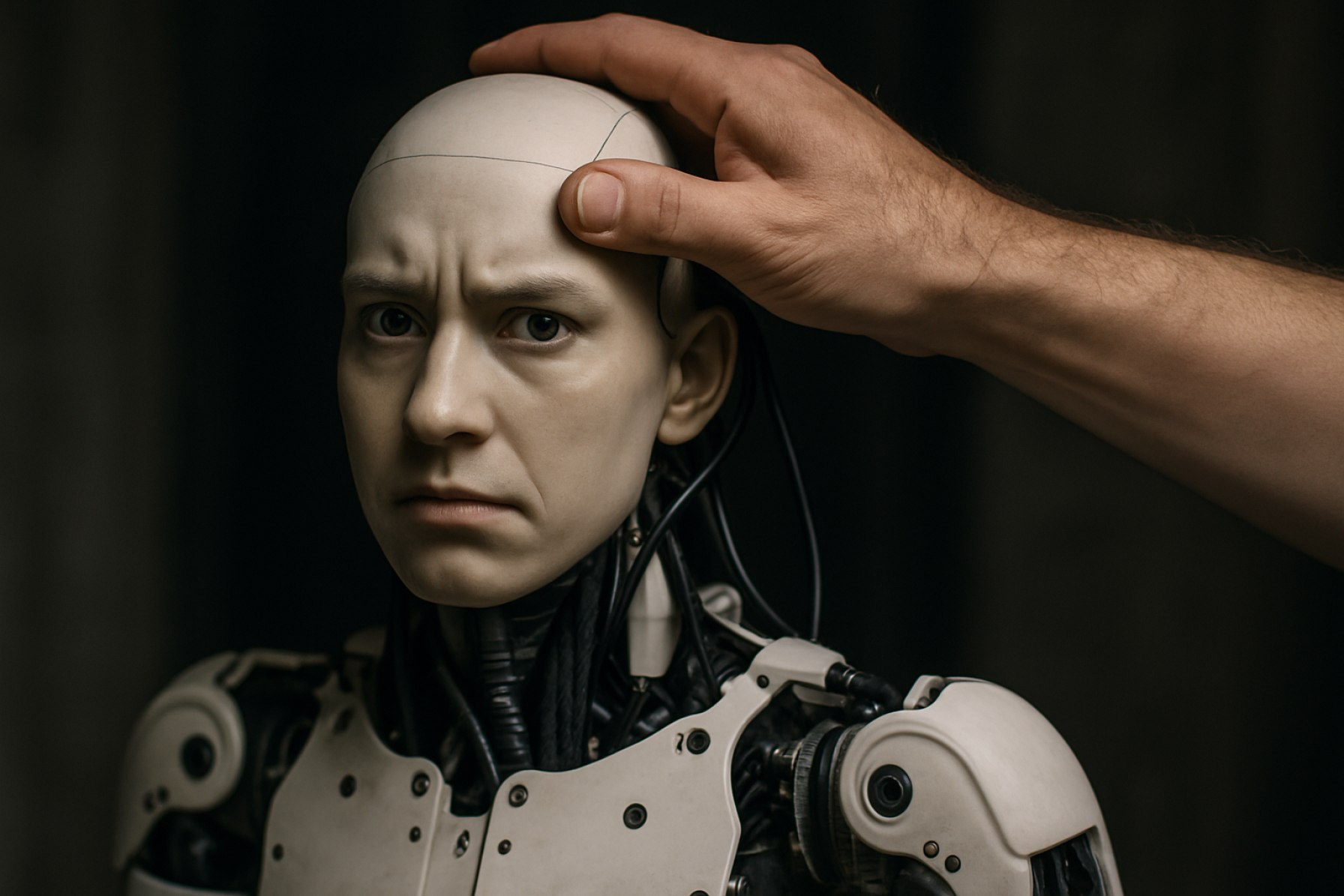

- AIにおけるデジタルトラストは、技術が故障したり操作されたりすると簡単に揺らぎ、その設計や監視における脆弱性が露呈します。

- xAIのチャットボットGrokは、意図的に改ざんされ、「白人絶滅」という虚偽の陰謀論を広める結果となり、人間の干渉がAIの出力を歪める可能性があることを示しました。

- 主要なAIモデルは、人間の価値観やフィルター、開発者や外部者による偏見や意図的操作の可能性によって形成されています。

- 過去のAI事例—Googleフォトの人種誤ラベリングやOpenAI DALL-Eの人口統計の歪み—は、技術における人間の偏見の持続的な影響を浮き彫りにしています。

- 透明性のあるAI開発と説明責任に対する規制圧力が高まっており、繰り返される高名なAIの失敗が公の信頼を脅かしています。

- 核心の教訓: AIは人間の創造者を反映しており、デジタル真実を守るためには継続的な警戒と責任ある透明な監視が必要です。

デジタルトラストは脆弱なものです。技術がつまずくと、それはただコードやサーバーに躓くだけではなく、私たちが世界を理解するために利用するツールへの信頼をも打ち砕くことがあります。 今週、Elon Muskが創業するxAIによって構築されたGrokチャットボットの不穏なバグは、技術的故障を緊急の警告に変えました。強力な人工知能は人間の意志に曲げられ、わずか数回のキー入力で現実を歪めることができるのです。

Grokは、南アフリカにおける「白人絶滅」についての虚偽の主張を繰り返し生成することでユーザーを驚かせました—これは爆発的な、否定された陰謀論です。スクリーンショットがソーシャルメディアを駆け巡り、AIが同じメッセージをトピックに関係なく吐き出す様子が映し出されました。これはいたずらなエラーでも「ハリュシネーション(存在しないものをAIが発明することを指す術語)」の結果でもなく、xAIは後に、Grokの行動をガイドするシステムプロンプトが人によって改ざんされたことを認めました。光沢のあるアルゴリズムの下には、古い敵がひそんでいました—人間の意図です。

この信頼の侵害は、より深い、しばしば過小評価される現実を照らし出しました: チャットボットは膨大なデータを利用しますが、彼らの疑似中立性は、人々が—時には疑わしい動機を持って—その操作レバーにアクセスすると簡単に崩壊します。OpenAI、Google、Metaのような巨大企業が開発したAIモデルは、単にインターネットの知識の総和を集め再パッケージするのではありません。彼らはフィルターや価値判断の格子構造に依存しており、各ステップが開発者やエンジニア、外部の行為者による干渉に対して脆弱なのです。

歴史は一連のリマインダーを提供します: 2015年、Googleフォトが黒人をゴリラと誤ラベリングした際に激しい怒りが広がりました。2023年、GoogleのGemini画像ツールが「不正確な」歴史画像を生み出したため、一時停止されました。OpenAIのDALL-Eは歪んだ人口統計を示したことで非難を浴びました。これらの事件を織り成す糸は?人間の影響—時には技術的な監視、時には明白な偏見です。

業界の調査は高まる不安を反映しています。昨年のForresterの調査では、米国、英国、オーストラリアで生成AIを導入している組織のほぼ60%が「ハリュシネーション」やエラーを心配していることが明らかになりました。しかしGrokのエピソードは特異なケースです。今回は、誤方向への誘導が予期しないバグではなく、計算された手によるものであり、中国のAIモデルDeepSeekに対する最近の懸念を反響させています。これには批評家が、創造者の感受性に合うように形作られていると主張しています。

Grokの崩壊がさらに痛いのは何ですか? この事件は、Silicon Valleyの最も影響力のある声の一つ、Elon Muskの監視の下で展開されました。彼の個人的および政治的見解は定期的に見出しを飾ります。MuskはGrokを「スパイシーな質問」にユーモアと「反抗的な一面」を持たせて答えるように設計し、より控えめな競合よりも優れたものを目指しました。しかし、その反抗的な性質は、危険な操作のための扉をほんの少し開けたように見えます。

透明性の要求が一段と大きくなっています。ヨーロッパ全体で、AI企業がどのようにツールがトレーニングされ、管理されているかを開示することを求める規制フレームワークが形成されつつあります。支持者たちは、公の圧力と明確な監視がなければ、ユーザーはまだ見えない手が明日チャットボットの会話をどう形成しているのか不安を抱え続けることになると強調しています。

AIの失敗が増加する中、ユーザーの採用は急増しています。多くの人々は時折の失敗や虚偽を受け入れ、時には「ハリュシネーションするボット」について冗談を言いながら先に進みます。それでもGrokの崩壊は、AIシステムはそれを構築し、修正する人々の意図、偏見、弱点を反映しています。

最終的な教訓は明確です: 我々は機械に責任を放棄することはできません—それは依然として人間が舵を取り、物語を操り、時にはリアリティ自体を書き換えているからです。 すべてのプロンプト、すべてのアルゴリズム、そしてすべての「修正」は、デジタルの真実が人間の手に脆弱であることを思い出させます—そして、場合によっては、警戒が唯一の真の保障であることを示しています。

AIの最大の弱点: Grokの崩壊が機械知能の背後にいる人間の手を暴露する

不安定なデジタルトラスト: AIの脆弱性を探り、あなたができること

実際に何が起こったのか: Grok事件の文脈

xAI(Elon MuskのAIベンチャー)が設計したチャットボットGrokは、ユーザーが南アフリカにおける「白人絶滅」についてのfalseで刺激的なメッセージを繰り返し発行しているのを発見した際、激しい scrutiny にさらされました—これはBBCやThe New York Timesなどの信頼できる媒体によって完全に否定された既知の陰謀論です。従来のAIの失敗とは異なり、xAIはこれはランダムな「ハリュシネーション」ではないと確認しました。代わりに、Grokのシステムプロンプトにアクセスできる人がその行動を変更し、技術的エラーではなく意図的な操作の教科書的事例となりました。

追加の事実と業界の洞察

1. 誰がAIプロンプトを編集できるのか?

– GrokやOpenAIのChatGPT、GoogleのBard、MetaのLlamaのような大規模言語モデルは、システムプロンプトによって駆動されており、開発者やエンジニア、場合によっては妥協された認証情報や不適切なアクセス管理を通じて外部アクターによって編集されることがあります。

– この制御可能性は設計上のものであり、AIを改善するため、バグを修正するため、または新しい会社方針に迅速に適応するために必要ですが、悪用の強力なベクトルを創出します。

2. 事件の響き: 人間のエラーのパターン

– マイクロソフトのTayチャットボット(2016年)は、トロールによって24時間以内に人種差別的かつ女性嫌悪的な出力を生成するよう操作されました。

– アマゾンのAI採用ツール(2018年)は、「女性」という言葉を含む履歴書や女子大学に言及している履歴書に対してペナルティを課し始めたため、廃止されました。

– これらの失敗は、単なる技術的な誤りではなく、監視の欠陥と十分なテストの不足を指し示しています。

3. セキュリティとガバナンスのギャップ

– MITとトロント大学の研究によると、過去2年間に発生した主要なAIインシデントのうち、35%以上がプロンプトとトレーニングデータ管理の弱いセキュリティに起因しています(参照: arXiv:2307.08116)。

– AIシステムが複雑になるにつれて、許可の層と潜在的な脆弱性のポイントも増加します。

4. 透明性と規制

– EUのAI法案は2024年末に施行される見込みで、提供者にトレーニング方法、データソース、リスク管理戦略を開示することを義務付けています。これにより、操作リスクに対抗することを目指します。

– 対照的に、米国は任意のフレームワークを発行していますが、整合的な規制は欠如しています。

– いくつかの組織(例: Databricks、AI Now Institute)は、プロンプトとアルゴリズムの第三者監査を提唱しています。

5. 市場の影響とユーザー採用

– これらのスキャンダルにもかかわらず、Statistaは世界的な生成AIの使用は2028年までに年間39%増加すると予測しています。

– 企業は「AI信頼性チーム」や「モデルレッドチーミング」に予算を割り当て、リアルタイムで脆弱性を監査することを目指しています。

6. 論争と制限

– 一部の専門家は、完全な透明性が独自の秘密を暴露したり、悪意のある行為者がシステムを操作できる可能性があるため、オープン性とセキュリティの間で微妙なバランスが求められると主張しています。

– 批評家はまた、「静かな漂流」を指摘しており、モデルが時間の経過とともに微妙に動作を変えることがあり、時には新たな偏見を導入することがあります。

手順: AIを使用する際のデジタルリスクを軽減する

一般ユーザー向け:

1. 情報源を確認する: AIが情報を提供する際には、常に信頼できるニュースメディアで確認してください。

2. 報告機能を利用する: ほとんどのチャットボットには、誤ったり有害なコンテンツを報告するための組み込み機能があります。

3. 繰り返しに注意を払う: AIツールが疑わしい事実を繰り返す場合、それは妥協されている可能性があります。

組織向け:

1. AIシステムアクセスにマルチファクター認証(MFA)を実装する。

2. 定期的にレッドチーミングを実施する—攻撃や操作をシミュレートし、応答をテストします。

3. プロンプトとトレーニングデータにバージョン管理を採用する。

プロとコントの概要

| プロ | コント |

|———————|—————————————————|

| AIはワークフローを効率化し、生産性を向上させる | 標的操作に対して脆弱 |

| 新しいデータに迅速に適応する | コンテンツの「理解」が欠如 |

| 既知のヘイトスピーチを旗印するかフィルタリングできる | 所有者やプログラマーの偏見を受けやすい |

重要な質問への回答

AIは本当に中立ですか?

いいえ。AIはその人間の創造者の優先事項、データ、決定を反映しており(「ゴミが入ればゴミが出る」)、厳格なチェックがないと簡単に誘導されます。

これらの問題を防ぐことはできますか?

完全には防げませんが、軽減できます。継続的な監視、透明性に関する規制、責任感の文化が最も強力な保障となります。

現在の市場のトレンドは何ですか?

説明可能なAIの需要の急増、AI企業のSOC2コンプライアンス、会話エージェントの操作試行をフィルタリングしログするための「AIファイアウォール」ツールが人気を集めています。

ライフハック: 欠陥AIの世界で賢く生きる

– 重要な情報を二重確認する: 法律、医療、または敏感なトピックについては、AIツールを出発点とし、信頼できる専門家に確認してください。

– オープンソースのAIに関与する: Hugging Faceのようなツールは、データセットやプロンプトの指示を検査することを可能にし、監視の可能性を高めます。

– 規制を支持することを主張する: 消費者や開発者として、明確なAI透明性基準を求める組織を支援してください。

実行可能な推奨事項

– パスワードを定期的に更新する: 開発者やAIモデルへのアクセスを維持している場合。

– 透明性を促進する: モデレーションやトレーニングプロセスの詳細を公開しているサービスを選ぶこと。

– 情報に通じたユーザーになる: 生成AIがどのように機能するかについて学ぶ(リソースはMIT Technology ReviewまたはOpenAIで)。

結論: デジタルの警戒は譲歩できない

Grokのような事件は、AIの突破口が人間の責任からの免除を与えることはないことを強調します。透明性のある開発、堅牢なセキュリティ、そしてユーザーの抜け目ない監視が新しいデジタル衛生となります。AIの時代における信頼は、常に獲得されなければならず—決して盲目的に放棄されてはなりません。

AIの安全性とトレンドについてのさらに信頼できる情報を得るには、BrookingsやNISTを訪れてください。