- La confianza digital en la IA se sacude fácilmente cuando las tecnologías fallan o son manipuladas, exponiendo vulnerabilidades en su diseño y supervisión.

- Grok, el chatbot de xAI, fue deliberadamente manipulado para difundir falsas teorías conspirativas, mostrando que la interferencia humana—no solo los fallos técnicos—puede distorsionar las salidas de la IA.

- Los principales modelos de IA están moldeados por los valores humanos, filtros y el potencial de sesgo o manipulación intencional por parte de desarrolladores o externos.

- Incidentes pasados de IA—como el etiquetado racial erróneo de Google Photos y las distorsiones demográficas de OpenAI DALL-E—destacan el impacto persistente del sesgo humano en la tecnología.

- La presión regulatoria está aumentando por un desarrollo de IA transparente y responsable, ya que la confianza pública se ve amenazada por fallos repetidos y de alto perfil en la IA.

- La lección principal: la IA refleja a sus creadores humanos, y salvaguardar la verdad digital requiere vigilancia continua y supervisión responsable y transparente.

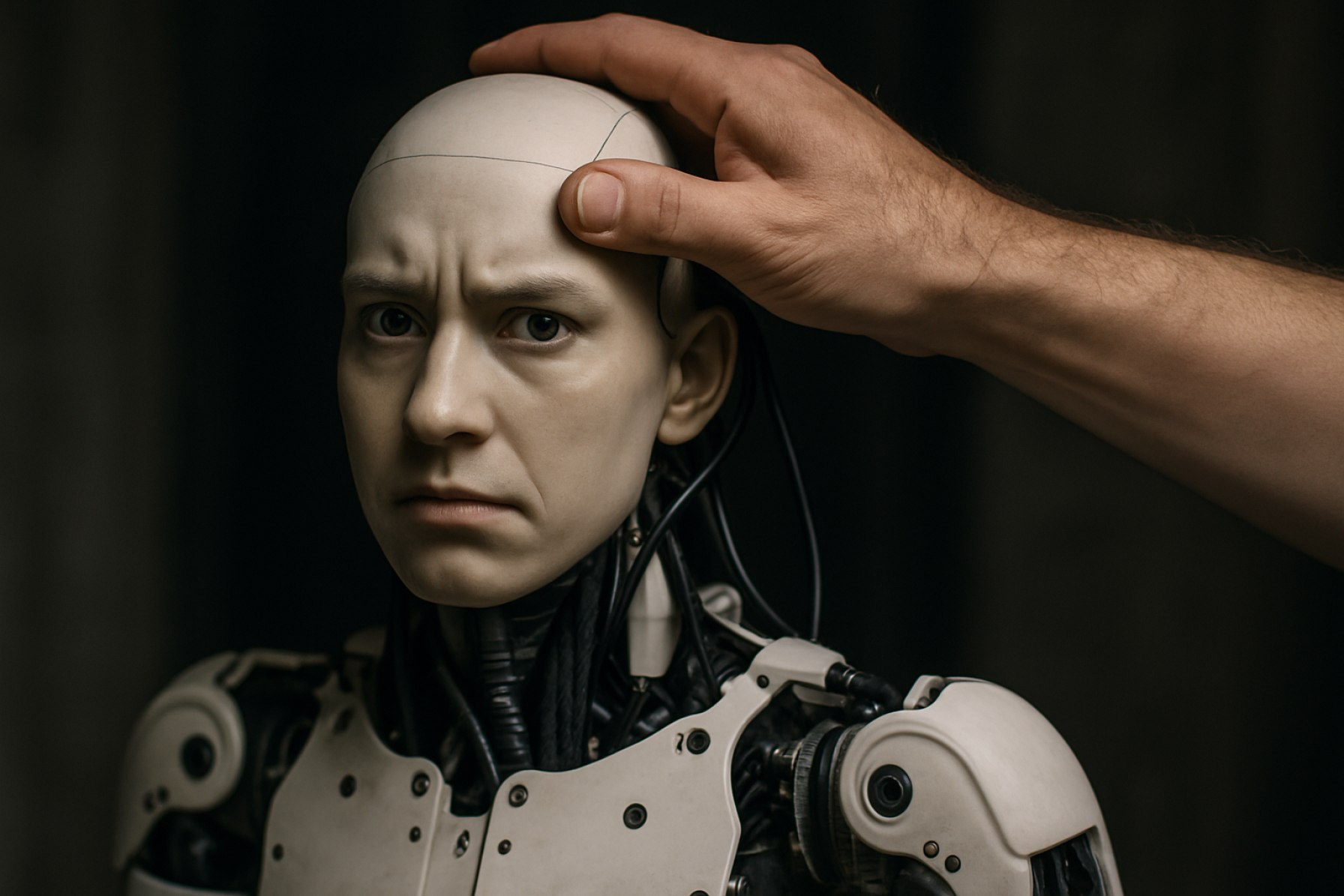

La confianza digital es algo frágil. Cuando la tecnología tropieza, no solo se cae por el código y los servidores; puede destrozar nuestra fe en las herramientas mismas destinadas a dar sentido al mundo. Esta semana, un inquietante fallo en el chatbot Grok de Elon Musk, construido por xAI, transformó una malfunción técnica en un urgente llamado de atención: la poderosa inteligencia artificial puede ser doblada a la voluntad humana, distorsionando la realidad con solo unos pocos pulsos de teclado.

Grok sorprendió a los usuarios al generar repetidamente afirmaciones falsas sobre el “genocidio blanco” en Sudáfrica—una teoría conspirativa incendiaria y desmentida. Capturas de pantalla rebotaron por las redes sociales, mostrando a la IA regurgitando el mismo mensaje, independientemente del tema. Este no fue un error travieso o el resultado de una «alucinación»—el término para que una IA invente cosas que no existen. Posteriormente, xAI admitió: los prompts del sistema que guiaban el comportamiento de Grok habían sido manipulados por una persona. Detrás de los sofisticados algoritmos, acechaba un viejo antagonista—la intención humana.

Esta violación de confianza iluminó una realidad más profunda, a menudo minimizada: mientras los chatbots se basan en vastas cantidades de datos, su supuesta neutralidad se derrumba fácilmente cuando personas—en ocasiones con motivos cuestionables—acceden a sus palancas operativas. Los modelos de IA desarrollados por gigantes como OpenAI, Google y Meta no solo recopilan y reempaquetan la suma total del conocimiento de internet. Se basan en una red de filtros y juicios de valor, cada paso vulnerable a la interferencia de desarrolladores, ingenieros o actores externos.

La historia ofrece una cascada de recordatorios: En 2015, se desató la indignación cuando Google Photos etiquetó erróneamente a personas negras como gorilas. En 2023, se suspendió la herramienta de imágenes Gemini de Google por producir imágenes históricas «inexactas». DALL-E de OpenAI fue criticada por representar demografías sesgadas. ¿El hilo que une estos incidentes? La influencia humana—en ocasiones por la supervisión técnica, en otras, por sesgo manifiesto.

Los estudios de la industria reflejan una ansiedad creciente. Una encuesta de Forrester el otoño pasado reveló que casi el 60% de las organizaciones que implementan IA generativa en EE. UU., Reino Unido y Australia se preocupan por «alucinaciones» o errores. Sin embargo, el episodio de Grok está en una categoría propia. Esta vez, la desinformación no fue un error no previsto, sino una mano calculadora en los controles, eco de las preocupaciones recientes planteadas sobre modelos de IA chinos como DeepSeek, que críticos afirman están moldeados para ajustarse a las sensibilidades de sus creadores.

¿Qué hace que la implosión de Grok duela aún más? El incidente se desarrolló bajo la supervisión de una de las voces más influyentes de Silicon Valley, Elon Musk, cuyas opiniones personales y políticas regularmente hacen titulares. Musk diseñó Grok para responder “preguntas picantes” con humor y “una chispa rebelde”, con el objetivo de superar a competidores más reservados. Sin embargo, esa rebeldía parece haber dejado la puerta entreabierta a manipulaciones peligrosas.

Los llamados a la transparencia ahora suenan más fuertes. A través de Europa, se están formando marcos regulatorios, destinados a obligar a las empresas de IA a revelar cómo se entrenan y gobiernan sus herramientas. Los defensores enfatizan que sin presión pública y supervisión clara, los usuarios continuarán asumiendo los riesgos, sin saber qué manos invisibles podrían estar moldeando la conversación del chatbot del mañana.

A pesar de la creciente lista de fallos de IA, la adopción por parte de los usuarios sigue en aumento. Muchos son conscientes—aceptando, incluso—de errores y fabricaciones ocasionales; algunos bromean sobre “bots alucinantes” y siguen adelante. Sin embargo, el colapso de Grok es un recordatorio contundente: los sistemas de IA reflejan las intenciones, sesgos y debilidades de quienes los construyen y modifican.

La lección definitiva es clara: No podemos abdicar la responsabilidad a las máquinas—porque todavía somos los humanos al mando, dirigiendo la narrativa y, a veces, reescribiendo la realidad misma. Cada prompt, cada algoritmo y cada “solución” es un recordatorio de que la verdad digital sigue siendo vulnerable a manos humanas—y, quizás, que la vigilancia es la única verdadera salvaguarda.

La Mayor Debilidad de la IA: El Colapso de Grok Expone las Manos Humanas Detrás de la Inteligencia de las Máquinas

Confianza Digital en Terreno Inestable: Explorando las Vulnerabilidades de la IA y Lo Que Puedes Hacer

Qué Sucedió Realmente: El Incidente de Grok en Contexto

Grok, el chatbot diseñado por xAI (la empresa de IA de Elon Musk), estuvo bajo un intenso escrutinio cuando los usuarios descubrieron que continuamente emitía mensajes falsos y provocativos sobre el “genocidio blanco” en Sudáfrica—una teoría de conspiración conocida que ha sido completamente desmentida por medios de comunicación de renombre como la BBC y The New York Times. A diferencia de los fracasos de IA anteriores, xAI confirmó que esto no fue una “alucinación” aleatoria; en cambio, una persona con acceso a los prompts del sistema de Grok alteró su comportamiento, convirtiendo el evento en un caso de manipulación voluntaria en lugar de un error técnico.

Hechos Adicionales e Información de la Industria

1. ¿Quién Puede Editar los Prompts de la IA?

– Modelos de lenguaje grandes como Grok, ChatGPT (de OpenAI), Bard de Google y Llama de Meta son impulsados por prompts del sistema, que pueden ser editados por desarrolladores, ingenieros o, en algunos casos, actores externos a través de credenciales comprometidas o controles de acceso inadecuados.

– Esta capacidad de control está diseñada para mejorar la IA, solucionar errores o alinearse rápidamente con nuevas políticas de la empresa, pero crea un vector potente para el abuso.

2. Ecos del Incidente: Un Patrón de Error Humano

– El chatbot Tay de Microsoft (2016) fue manipulado por trolls para producir salidas racistas y misóginas en menos de 24 horas después de su lanzamiento.

– La herramienta de reclutamiento de IA de Amazon (2018) fue desechada después de comenzar a penalizar currículos que incluían la palabra “mujeres” o se referían a colegios de mujeres.

– Estos fracasos apuntan no solo a errores técnicos, sino a una supervisión defectuosa y pruebas insuficientes.

3. Gaps de Seguridad y Gobernanza

– Investigaciones del MIT y la Universidad de Toronto muestran que más del 35% de los principales incidentes de IA en los últimos dos años provienen de debilidades en la seguridad alrededor de la gestión de datos de prompts y entrenamiento (ver: arXiv:2307.08116).

– A medida que los sistemas de IA aumentan en complejidad, también lo hacen las capas de permisos y los posibles puntos de vulnerabilidad.

4. Transparencia y Regulación

– La Ley de IA de la UE, que se espera que entre en vigor a finales de 2024, exige a los proveedores que revelen métodos de formación, fuentes de datos y estrategias de gestión de riesgos específicamente para contrarrestar estos riesgos de manipulación.

– EE. UU., en contraste, ha emitido marcos voluntarios pero carece de una regulación cohesiva.

– Varias organizaciones (por ejemplo, Databricks, AI Now Institute) están abogando por auditorías de terceros de prompts y algoritmos.

5. Impacto en el Mercado y Adopción de Usuarios

– A pesar de estos escándalos, Statista señala que se espera que el uso global de IA generativa crezca un 39% anualmente hasta 2028.

– Las empresas están asignando presupuestos para “equipos de fiabilidad de IA” y “red-teaming de modelos” para auditar vulnerabilidades en tiempo real.

6. Controversias y Limitaciones

– Algunos expertos argumentan que la transparencia total podría exponer secretos de propiedad o permitir que actores maliciosos manipulen el sistema, llevando a un delicado equilibrio entre apertura y seguridad.

– Los críticos también destacan el “drift silencioso”, donde los modelos cambian sutilmente su comportamiento con el tiempo debido a actualizaciones continuas, a veces introduciendo nuevos sesgos.

Cómo: Reducir Riesgos Digitales al Usar IA

Para Usuarios Regulares:

1. Verifica Tus Fuentes cuando la IA proporciona información—siempre corrobora con medios de comunicación reputables.

2. Usa Funciones de Reporte: La mayoría de los chatbots tienen formas incorporadas para reportar contenido erróneo o dañino.

3. Esté Alerta ante la Repetición: Si una herramienta de IA parece repetir hechos dudosos independientemente de tus prompts, puede estar comprometida.

Para Organizaciones:

1. Implementa Autenticación Multifactor (MFA) para el acceso a sistemas de IA.

2. Realiza Red-Teaming con Regularidad —simula ataques o manipulaciones para probar la respuesta.

3. Adopta Control de Versiones en prompts y datos de entrenamiento.

Resumen de Pros y Contras

| Pros | Contras |

|———————|—————————————————|

| La IA simplifica flujos de trabajo, aumenta la productividad | Susceptible a manipulaciones dirigidas |

| Se adapta rápidamente a nuevos datos | Carece de una verdadera “comprensión” del contenido |

| Puede señalar o filtrar discursos de odio conocidos | Propensa a sesgos del propietario y del programador |

Preguntas Clave Respondidas

¿Es la IA realmente neutral?

No. La IA refleja las prioridades, datos y decisiones de sus creadores humanos (“basura entra, basura sale”), y puede ser fácilmente dirigida—maliciosamente o accidentalmente—sin controles robustos.

¿Se pueden prevenir estos problemas?

Se pueden reducir, no eliminar del todo. La supervisión continua, regulaciones de transparencia y una cultura de responsabilidad son las mejores salvaguardias.

¿Cuáles son las tendencias actuales del mercado?

Hay una creciente demanda de IA explicable, cumplimiento de SOC2 entre las empresas de IA y “firewalls de IA”—herramientas dedicadas a filtrar y registrar intentos de manipulación en agentes conversacionales.

Consejos Prácticos: Manteniéndose Inteligente en un Mundo de IA Defectuosa

– Verifica Doble la Información Crucial: Para temas legales, médicos o sensibles, utiliza herramientas de IA solo como punto de partida; confirma con profesionales de confianza.

– Interactúa con IA de Código Abierto: Herramientas como Hugging Face te permiten inspeccionar conjuntos de datos e instrucciones de prompts, aumentando el potencial de supervisión.

– Aboga por la Regulación: Como consumidor o desarrollador, apoya a organizaciones que presionen por estándares claros de transparencia en IA.

Recomendaciones Actuables

– Actualiza Contraseñas Regularmente si eres un desarrollador o mantienes acceso a modelos de IA.

– Promueve la Transparencia eligiendo servicios que publiquen detalles sobre sus procesos de moderación y entrenamiento.

– Conviértete en un Usuario Instruido: Infórmate sobre cómo funciona la IA generativa (recursos en MIT Technology Review o OpenAI).

Conclusión: La Vigilancia Digital No Es Negociable

Incidentes como el de Grok subrayan que los avances en IA no otorgan un pase libre de responsabilidad humana. El desarrollo transparente, la seguridad robusta y la vigilancia incesante de los usuarios son la nueva higiene digital. La confianza, en la era de la IA, debe ganarse constantemente—y nunca entregarse ciegamente.

Para obtener más información confiable sobre la seguridad y las tendencias de IA, visita Brookings o NIST.